-

Il rilevamento delle porte utilizzerà uno scanner LiDAR e l’apprendimento automatico per identificare le porte e trasmettere informazioni sulla loro posizione, marcatura e altro per utenti non vedenti o ipovedenti.

-

La trascrizione automatica trascrive ciò che le persone dicono nelle chiamate e nei video durante l’utilizzo del telefono.

-

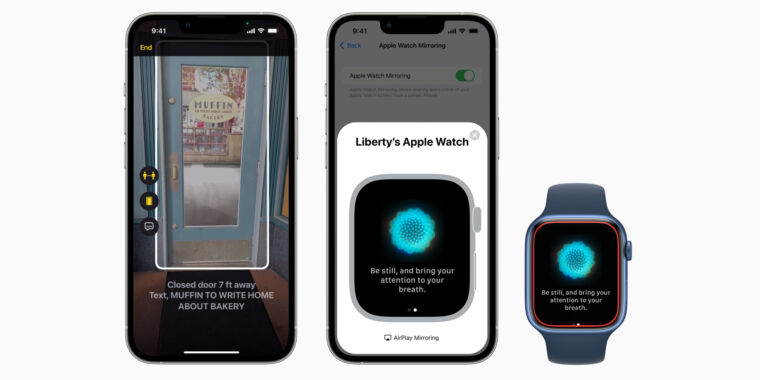

Il mirroring dello schermo di Apple Watch consentirà agli utenti di Watch di accedere ad alcune funzionalità di accessibilità disponibili su iPhone ma non su Watch.

-

Gli utenti potranno impostare per quanto tempo Siri attende che tu finisca di parlare prima di rispondere o eseguire un’azione.

-

I gesti tattili aggiunti offriranno agli utenti più modi per controllare l’Apple Watch.

-

Sarai in grado di addestrare il tuo iPhone a riconoscere suoni importanti come un campanello.

-

L’app Apple Books introduce nuove opzioni di personalizzazione per rendere il testo più visibile.

La Giornata mondiale per la sensibilizzazione all’accessibilità è giovedì, quindi Apple l’ha iniziata Blog della redazione Questa settimana per annunciare diverse nuove importanti funzionalità di accessibilità in arrivo su iPhone, Apple Watch, iPad e Mac.

La funzione Live Captions sarà probabilmente la più utilizzata, che sarà disponibile su iPhone, Mac e iPad. La funzione mostra i sottotitoli AI che vengono aggiornati in tempo reale per la voce proveniente da qualsiasi sorgente audio sul telefono, indipendentemente dal fatto che l’utente sia “su una chiamata telefonica o FaceTime, utilizzando una videoconferenza o un’app di social media, streaming di contenuti multimediali o conversando con qualcuno accanto a loro”.

Il testo (che gli utenti possono ridimensionare a piacimento) appare nella parte superiore dello schermo e indica mentre il soggetto sta parlando. Inoltre, gli utenti Mac potranno digitare le risposte e farle leggere ad alta voce agli altri partecipanti alla chiamata. I sottotitoli in tempo reale entreranno in versione beta pubblica sui dispositivi supportati (“iPhone 11 e versioni successive, modelli iPad con chip A12 Bionic e versioni successive e Mac con silicio Apple”) entro la fine dell’anno.

C’è anche una funzione di rilevamento della porta. Sfortunatamente, funzionerà solo su iPhone e iPad con un sensore lidar (come iPhone 12 Pro, iPhone 13 Pro o i recenti modelli di iPad Pro), ma sembra utile per le persone non vedenti o ipovedenti. Utilizza la fotocamera dell’iPhone e i sensori di realtà aumentata, insieme all’apprendimento automatico, per individuare le porte e dire agli utenti ad alta voce dove si trova la porta, se è aperta o chiusa, come può essere aperta e cosa potrebbe essere per scrivere o adesivi.

Il rilevamento delle porte si unirà alla scoperta di persone e descrizioni di foto nella nuova “Modalità di rilevamento” per utenti non vedenti e ipovedenti in iOS e iPadOS. Tuttavia, il post sul blog di Apple non ha menzionato quando verrà lanciata questa funzione.

Altre aggiunte all’accessibilità che secondo Apple sono molto vicine includono 20 nuove lingue Voice Over, nuovi gesti delle mani sull’Apple Watch e una funzione che consente ai giocatori di chiedere aiuto a un “amico” con un’altra console di gioco senza disconnettersi da loro. Inoltre, ci sono nuove personalizzazioni di Siri e Apple Books che mirano a espandere l’accessibilità per le persone con disabilità, personalizzazioni del riconoscimento vocale e mirroring dello schermo di Apple Watch su iPhone, che offre agli utenti di Watch l’accesso a molte delle funzionalità di accessibilità disponibili su iPhone ma non sull’orologio. .

Gli appassionati di tecnologia spesso si lamentano del fatto che gli smartphone (e la tecnologia personale in generale) siano diventati stagnanti, senza molti nuovi entusiasmanti sviluppi. Ma questo è lontano dalla verità per molte persone con disabilità. Google, Apple e molti ricercatori e startup hanno compiuto importanti progressi, introducendo nuove potenti funzionalità di accesso ai dispositivi mobili.

Elenco immagini di Mela