“Penso che ci permetta di essere più premurosi e più riflessivi sui problemi di sicurezza”, afferma Altman. “Parte della nostra strategia è: il cambiamento incrementale nel mondo è meglio del cambiamento improvviso”. Oppure, come ha affermato Mira Moratti, vicepresidente di OpenAI, quando le ho chiesto del lavoro del team di sicurezza che limita l’accesso aperto al software, “Se vogliamo imparare a implementare queste potenti tecnologie, iniziamo quando la posta in gioco è molto bassa .”

Mentre GPT-3 stesso In esecuzione su 285.000 core di CPU in un cluster di supercomputer in Iowa, OpenAI opera fuori dall’area Mission di San Francisco, in una fabbrica di bagagli ristrutturata. Nel novembre dello scorso anno, ho incontrato Ilya Sotskefer lì, cercando di ottenere una spiegazione da profano di come funziona davvero GPT-3.

“Questa è l’idea di base del GPT-3”, ha detto Sotskever intensamente, sporgendosi in avanti sulla sedia. Ha un modo interessante di rispondere alle domande: alcune false partenze – “Posso darti una descrizione che corrisponde grosso modo alla descrizione che hai chiesto” – interrotte da lunghe pause meditative, come se stesse tracciando l’intera risposta in corso.

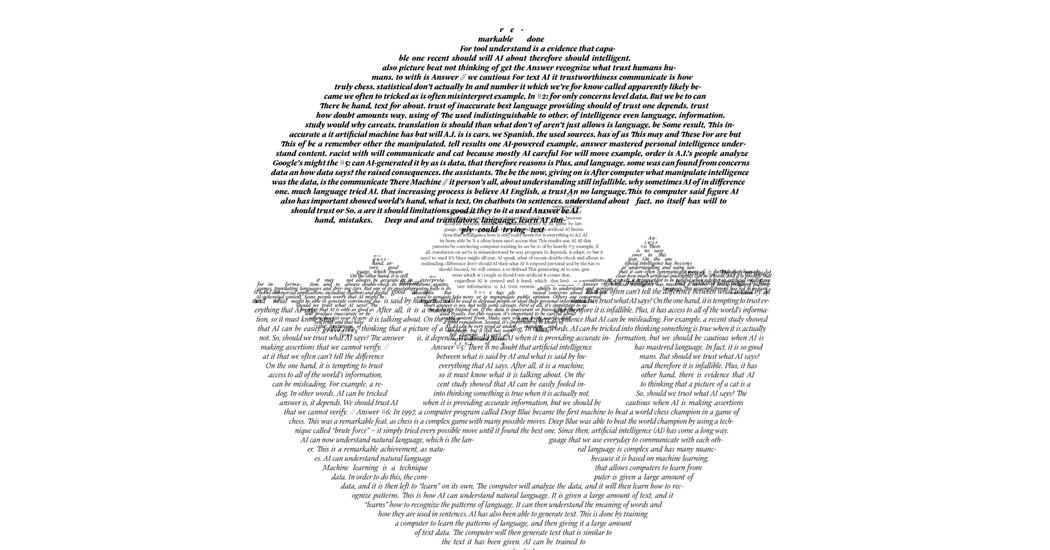

Alla fine disse: “L’idea di base di GPT-3 è un modo per mettere in relazione una nozione intuitiva di comprensione con qualcosa che può essere misurato e compreso meccanicamente, e questo è il compito di predire la parola successiva nel testo. Altre forme di intelligenza artificiale tentano di codificare informazioni sul mondo: le strategie scacchistiche dei grandi maestri, i principi della climatologia. Ma l’intelligenza GPT-3, se intelligenza è la parola giusta, viene dal basso verso l’alto: attraverso il verbo elementare per predire la parola successiva. Per l’addestramento GPT-3, al modello viene fornito un “richiesta” – alcune frasi o paragrafi di testo da un articolo di giornale, ad esempio, o un romanzo o un articolo scientifico – e quindi viene chiesto di suggerire un elenco di possibili parole che potrebbe completare la sequenza, ordinata per probabilità. Nelle prime fasi della formazione, le parole proposte non hanno senso. Chiedi all’algoritmo con una frase del tipo “Lo scrittore ha cancellato l’ultima parola dalla prima parola . . . “” e le ipotesi sarebbero una sorta di flusso di sciocchezze: list – appare la parola mancante corretta: “paragrafo”. Quindi il programma rafforza e indebolisce tutte le connessioni neurali casuali che generano quel particolare suggerimento Tutte le connessioni che hanno generato ipotesi errate. Quindi passa al router successivo. Nel tempo, con un numero sufficiente di iterazioni, il programma impara.

A gennaio, OpenAI ha aggiunto una funzionalità che consente agli utenti di fornire istruzioni GPT-3 dirette come prompt, piuttosto che richiedere loro di estendere un segmento di testo di esempio. Ad esempio, utilizzando la modalità Guida, una volta GPT-3 riceveva il messaggio: “Scrivi un saggio che discuta il ruolo della metafiction nell’opera di Italo Calvino”. Un breve paragrafo iniziato così:

L’autore italiano Italo Calvino è considerato un esperto di metafiction, un tipo di scrittura in cui l’autore rompe il quarto muro per discutere dell’atto stesso della scrittura. Per Calvino, la metafiction è un modo per esplorare la natura della realtà e i modi in cui le storie possono plasmare la nostra percezione del mondo. I suoi romanzi spesso includono strutture giocose e labirinti che manipolano i confini tra realtà e fantasia. Nel caso in cui il viaggiatore si trovi in una notte d’inverno, ad esempio, il lettore è costantemente interrotto da discussioni al meta-livello dell’atto di leggere e dalla natura della narrazione. . . .

Puoi dare a GPT-3 lo stesso identico prompt, ancora e ancora, e ogni volta genererà una risposta unica, alcune più persuasive di altre ma quasi tutte straordinariamente semplici. I suggerimenti indicativi possono assumere tutti i tipi di forme: “Dammi un elenco di tutti gli ingredienti nel ragù alla bolognese”, “Scrivi una poesia su un villaggio di mare francese in stile John Ashbery”, “Spiega il Big Bang in un linguaggio che un 8 anni -il vecchio capisce.” A volte i primi che ho alimentato con stimoli GPT-3 di questo tipo, ho sentito una vera pelle d’oca scorrermi lungo la schiena. Sembrava quasi impossibile per una macchina generare un testo così chiaro e reattivo interamente basato sull’allenamento iniziale per prevedere la parola successiva.

Ma l’IA ha una lunga storia nel creare l’illusione dell’intelligenza o della comprensione senza effettivamente fornire i beni. A carta molto discussa Pubblicato l’anno scorso, la professoressa di linguistica dell’Università di Washington Emily Bender, l’ex ricercatore di Google Timnit Gebru e un gruppo di coautori hanno dichiarato che i modelli linguistici di grandi dimensioni erano solo “pappagalli casuali”: ovvero, il programma utilizzava la randomizzazione solo per remixare le frasi scritte da umani. . Di recente Bender mi ha detto via e-mail: “Ciò che è cambiato non è qualche gradino al di sopra di una certa soglia verso l'”intelligenza artificiale”. Invece, ha detto, ciò che è cambiato sono “hardware, software ed innovazioni economiche che consentono l’accumulo e l’elaborazione di enormi set di dati’ — così come la cultura La tecnologia che “le persone che costruiscono e vendono tali cose possono avere” è ben lungi dal costruirla su basi di dati imprecisi.”

/cdn.vox-cdn.com/uploads/chorus_asset/file/25546355/intel_13900k_tomwarren__2_.jpg)